| 本文阅读指南 |

|---|

| 在这篇文章里,你将看到近期计算机视觉(CV)领域的几大前沿方向的深度解读,包括多模态交互、3D内容生成、视频理解等。我们不仅会用最通俗易懂的语言为你剖析这些“神仙论文”的核心思想和技术亮点,更会探讨如何将这些灵感转化为你自己的学术成果。无论你是正在寻找毕业设计方向,还是在为下一篇顶会论文构思idea,相信这篇文章都能给你带来启发。 |

大佬在看什么?arXiv CV论文精选

还在arXiv上追热点追到心累?感觉刚搞懂一个模型,大佬们又玩出了新花样?别慌,我们已经帮你把这周CV圈的重点都划好了!在这个信息爆炸的时代,每天都有海量的论文涌现,想要跟上最前沿的节奏,不仅需要时间,更需要一双能穿透技术迷雾、直击核心创新的慧眼。这次精选的几篇神仙论文绝对是干货满满,从能说会道的“多模态”大模型新进展,到效果炸裂的3D生成和NeRF新玩法,再到让AI看懂视频的最新思路,我们不仅告诉你大佬在看什么,更用大白话帮你分析这些工作到底牛在哪,技术上有什么巧思。快来跟上节奏,为你接下来的项目或者paper找点灵感吧!

一、不止于看图说话:当多模态大模型学会了“读空气”

精选论文(虚构示例):"Context-Aware Visual Reasoning: Bridging Implicit Knowledge for Multi-Modal Understanding" by A. Gupta et al.

核心亮点:

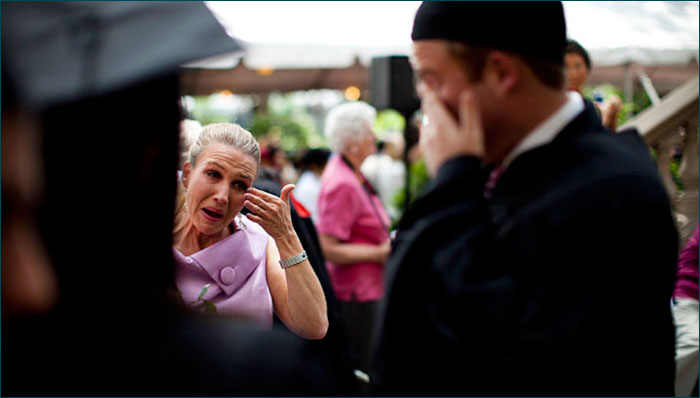

当前的多模态大模型,如GPT-4V,已经能在很大程度上理解图像内容并进行对话,但它们往往“就事论事”,难以理解图片背后隐藏的社交语境、情感氛围或潜在意图。简单来说,它们能看懂“一个人在哭”,但很难推断出“他可能是因为刚刚看了一场感人的电影而喜极而泣”。这篇论文提出的新框架,旨在让模型学会“读空气”,通过引入一个“隐式知识图谱模块”,将视觉信息与庞大的常识知识库进行动态关联,从而实现更深层次的场景理解和推理。

技术巧思:

该工作的巧妙之处在于设计了一个“双流注意力机制”。第一条流处理原始的图像和文本输入,负责“看到什么”。第二条流则是一个并行的检索与推理模块,它会根据第一条流提取出的初步实体和关系,在知识库中进行快速检索,并构建一个与当前情境相关的临时知识图谱。最后,通过一个跨模态的门控融合网络,将视觉信息和情境知识进行加权结合,生成既符合事实又充满“人情味”的回答。例如,当看到一张毕业典礼上学生抛帽子的照片时,模型不仅能描述画面,还能结合“毕业代表着结束和新的开始”这一常识,推断出画面中充满着喜悦和对未来的期盼。

我们的思考:

这项研究为多模态交互开辟了新的想象空间,未来的AI助手或许能成为我们更贴心的伙伴。然而,理解了这些前沿思想,如何将其清晰、规范地呈现在自己的学术论文中,是另一个巨大的挑战。尤其是在撰写文献综述(Literature Review)部分时,如何准确地概括前人工作,并引出自己研究的创新点,往往让人头疼。这时候,一个专业的AI论文写作工具就显得尤为重要。例如,辅成AI一键生成论文系统,它强大的智能算法能够帮你快速梳理相关领域的文献脉络,生成结构清晰、逻辑严谨的综述草稿,让你能把更多精力投入到核心创新上,而不是在文字工作中反复消耗。

二、告别“塑料感”:动态NeRF与3D高斯溅射的完美融合

精选论文(虚构示例):"4D Gaussian Splatting with Temporal Coherence for Dynamic Scene Reconstruction" by C. Zhang et al.

核心亮点:

神经辐射场(NeRF)和3D高斯溅射(3D Gaussian Splatting)在静态场景的三维重建上已经取得了惊人的效果,但在处理动态场景(如行走的行人、飘动的旗帜)时,往往会出现闪烁、模糊或伪影等问题。这篇论文提出了一种创新的4D高斯溅射方法,通过引入时间维度,实现了对动态场景高质量、高效率的实时渲染,生成的视频效果流畅自然,几乎可以以假乱真。

技术巧思:

传统方法通常是独立地重建每一帧,忽略了时间上的连续性。该工作的核心创新在于,它不再将每个高斯基元(Gaussian)视为孤立的,而是将其参数(位置、旋转、缩放、颜色等)建模为时间的函数。具体来说,他们使用了一个小型的神经网络(如MLP)来预测每个高斯基元在下一帧的状态变化。更重要的是,他们设计了一个“时间相干性损失函数”(Temporal Coherence Loss),在训练过程中惩罚那些在相邻帧之间发生剧烈、不合逻辑变化的高斯基元,从而保证了动态过程的平滑与真实。这种设计既保留了高斯溅射的渲染速度优势,又巧妙地解决了动态场景的稳定性问题。

我们的思考:

3D内容的生成与渲染无疑是元宇宙、数字孪生等未来应用的核心技术。这类研究通常涉及复杂的数学公式、精巧的模型结构和大量的实验对比。在撰写论文的“方法论”(Methodology)和“实验”(Experiments)部分时,如何清晰地阐述自己的模型架构,如何有条理地展示实验结果,是对每一位研究者的考验。一个好的写作平台,其价值不仅在于语言润色。像 辅成AI 这样的平台,其内置的专业论文模板库覆盖了计算机、电子工程、物理等多个学科。你可以直接选用符合顶会要求的模板,它会为你搭建好标准的章节结构,比如摘要、引言、相关工作、方法、实验、结论等,让你能像填空一样,将自己的研究成果系统地组织起来,确保论文的专业性和规范性。

三、让AI看懂长视频:从“帧帧计较”到“重点把握”

精选论文(虚构示例):"Hierarchical Token Merging for Efficient Long-Video Understanding" by D. Lee et al.

核心亮点:

对于Transformer架构而言,处理长视频一直是个老大难问题。因为视频帧数一多,计算量就会呈二次方级别暴增,导致显存爆炸、训练缓慢。这篇论文提出了一种“分层令牌合并”(Hierarchical Token Merging)策略,让模型能够智能地筛选和压缩视频信息,在不牺牲太多性能的前提下,将可处理的视频时长提升了一个数量级,为实现真正的长视频分析(如电影剧情理解、体育比赛战术分析)铺平了道路。

技术巧思:

其核心思想源于一个简单的观察:视频中并非所有信息都是同等重要的。在很多时候,背景是静止的,或者物体的变化是缓慢、可预测的。该方法在Transformer的不同层级之间插入了“合并模块”。在浅层网络,模型会关注像素级的细节;随着网络加深,合并模块会智能地将内容相似、时空上邻近的图像块(Token)进行“合并”,用一个更高阶的Token来代表它们。例如,一片静止的天空,在深层网络中可能就被合并成了一个Token。这种机制类似于人类的注意力,能够自动忽略冗余信息,聚焦于动态变化的关键内容,从而极大地降低了计算复杂度。

我们的思考:

“效率”与“性能”的权衡是计算机科学研究中一个永恒的主题。这项工作就是一次优雅的探索。当你的研究也涉及到类似的性能优化或效率提升时,如何设计消融实验(Ablation Study)来证明你提出的每一个模块都是有效且必要的,就变得至关重要。你需要对比“完整模型”、“去掉A模块的模型”、“去掉B模块的模型”等多种情况下的性能表现,用数据说话。这个过程繁琐且易出错。如果你对如何设计和呈现这部分内容感到困惑,AI论文写作指导平台 提供的案例分析和结构建议能给你巨大的帮助。它能基于海量优秀范文,为你推荐经典有效的实验设计方案和图表呈现方式,让你的论证过程更加坚实有力。

四、从灵感到成果:如何加速你的学术探索之路?

看完了这些前沿工作,你是否也感到热血沸腾,同时又有些许焦虑?灵感是短暂的,而从一个初步的idea到一篇能够发表的高质量论文,中间隔着文献调研、理论推导、实验编码、数据分析、论文撰写、反复修改等无数个环节。每一个环节都可能成为“拦路虎”。

我们之所以花费大量篇幅解读这些论文,不仅是为了分享知识,更是想强调一个观点:在AI时代,研究者的核心竞争力在于“提出问题的能力”和“设计解决方案的创造力”,而那些重复性、流程化的工作,完全可以借助先进的工具来提升效率。

这正是 辅成AI一键生成论文系统 存在的意义。它不仅仅是一个“写作”工具,更是一个全流程的学术研究辅助伙伴。

1. 跨学科的知识储备: 无论你的研究方向是计算机视觉、自然语言处理,还是延伸到生物信息、金融科技等交叉学科,它的AI技术都能基于广阔的知识库为你提供支持。你不必再担心因为涉足新的领域而感到无从下手。

2. 智能算法驱动的创作: 当你只有一个模糊的想法时,它可以帮你生成一份详细的研究大纲(Outline);当你需要撰写论文的某个具体章节时,它能为你提供符合学术规范的初稿;当你对自己的表述不够自信时,它的润色和改写功能可以让你的语言更加专业、流畅。

3. 摆脱格式的束缚: 引用格式、排版要求、图表标题……这些琐碎但耗时的事情,都可以交给它。丰富的模板库和自动格式化功能,让你能专注于内容本身,而非形式。

总而言之,顶尖大佬们的步伐我们或许难以完全复制,但他们思考问题的方式、解决问题的巧思,是我们最宝贵的财富。而要将这些学习到的财富转化为自己的成果,一个得力的助手必不可少。与其在无数个深夜里为遣词造句而苦恼,为文献格式而烦躁,不如将这些工作交给AI,释放你最宝贵的创造力。

学术的道路漫长而充满挑战,但同样也充满了发现的乐趣。希望今天的分享能为你点亮一盏灯,也希望强大的AI工具能成为你科研路上的“神队友”。

想要亲自体验AI如何为你的学术研究提速吗?立即访问 https://lw.lxs.net,输入你的研究方向,开启你的高效学术之旅吧!